ViT中枢作家Lucas Beyer百家乐ag厅投注限额,长文分析了一篇改良Transformer架构的论文,引起推选围不雅。

他前不久从谷歌跳槽到OpenAI,此次是在飞机上阅读论文并写下了分析。

这篇论文被他简写为DiffTranformer,不外不是Sora底层架构的阿谁Diffusion Transformer,而是不久前来自微软的Differencial Transformer。

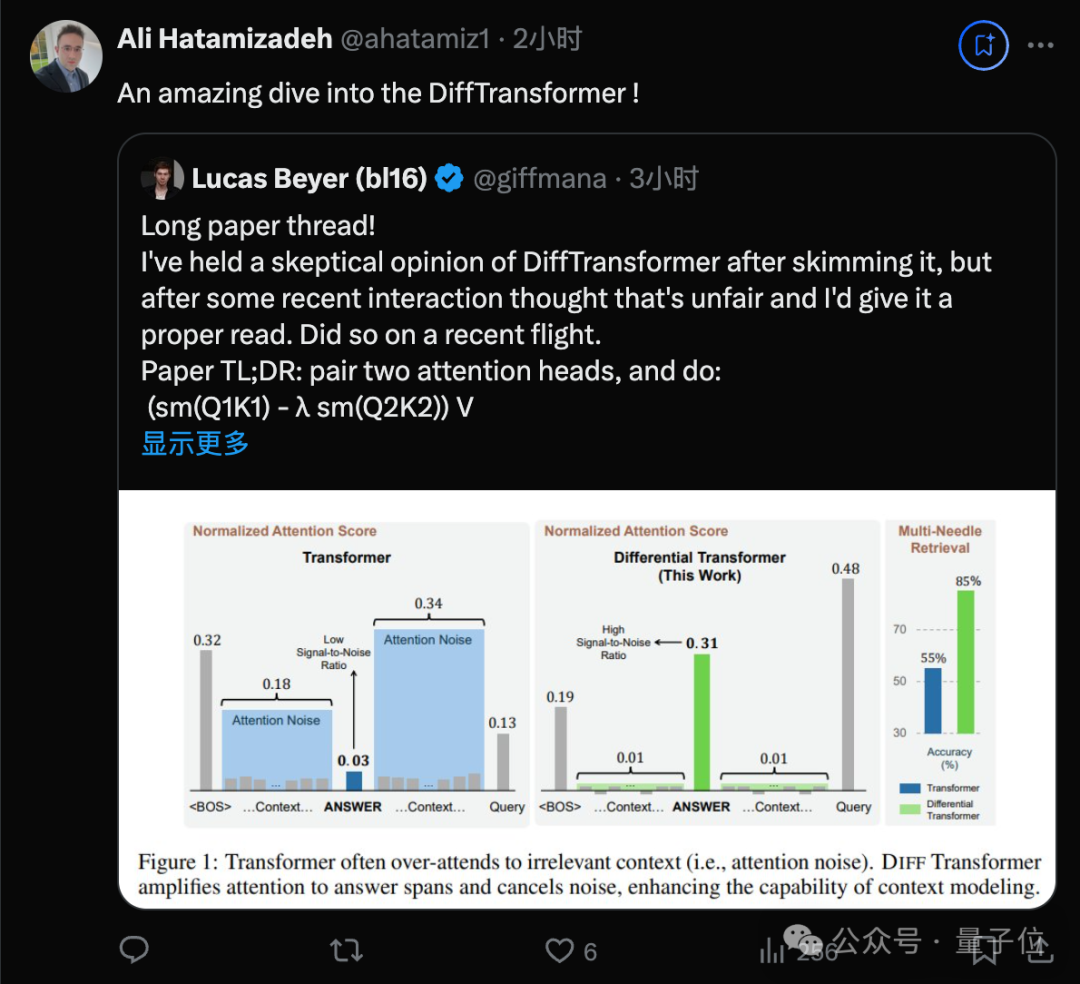

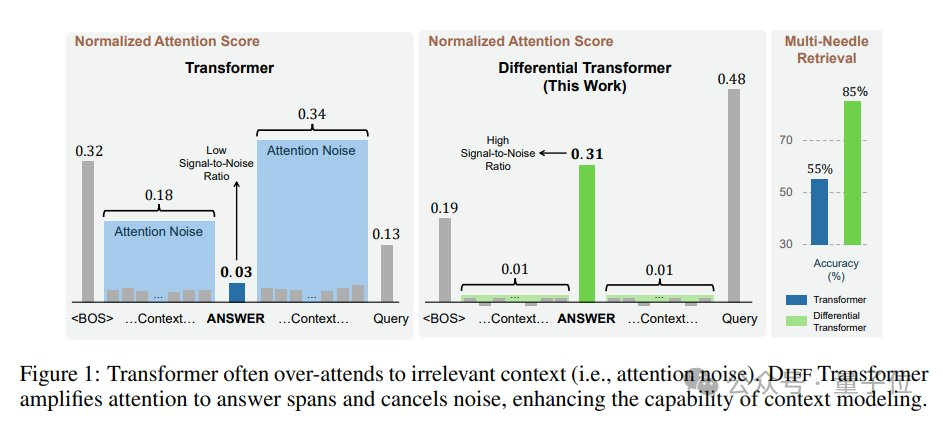

论文中先容,全体念念路肖似差分放大电路或降噪耳机,用两个信号的差值来滤除共模噪声,科罚Transformer模子信噪比低的问题。

这篇论文发布时引起无数温文,但也濒临一些质疑,在弹幕版alphaXiv上作家与读者进行了好多商议。

Beyer着手也对这篇著述抓保留魄力,以为“难说念MHA中的两个老成力头弗成学习到这些吗?”。

但经由近期和同业的一些互动,以为不应该放浪下定论,重新看了一遍论文后,他调动了认识

我的当先印象被团队的实际透彻败坏了,他们的实际相称公良善严慎。

此外还有一个彩蛋:

大佬庸俗会用坐飞机的时辰来打4把Dota 2游戏快速花样。

咫尺写这个帖子也弗成当论文评审职责写进简历,是纯纯的孝敬个东说念主时辰了,以后也不会常写。

总之先给大佬点赞。

大佬解读热门论文

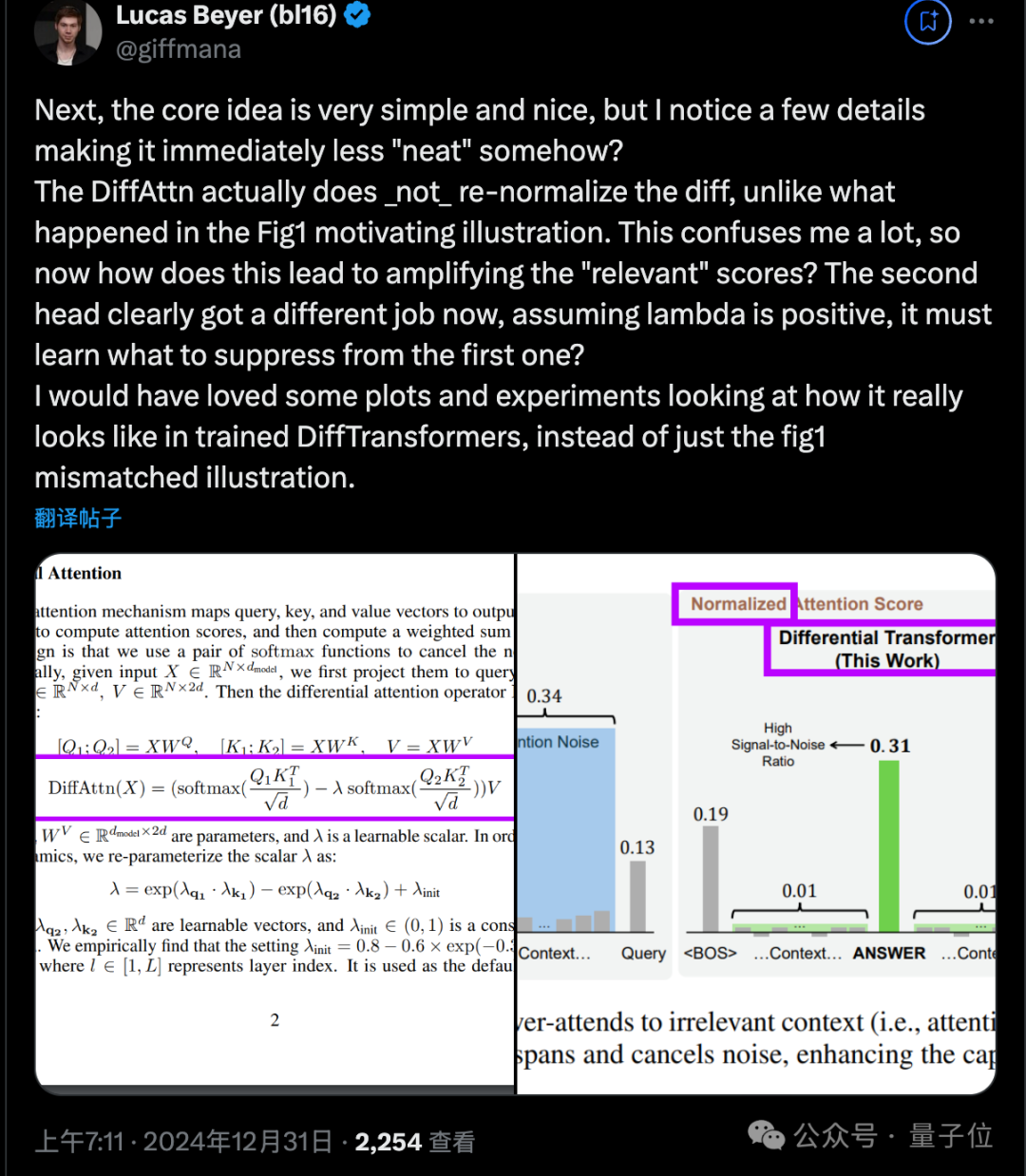

Beyer评价这篇论文的中枢转换相称simple和nice,不错用一句话抽象。

将两个老成力头配对,然后引申(softmax(Q1K1) - λ*softmax(Q2K2)) V,其中λ是一个可学习的标量。

他认为这项接头的动机相称充分:跟着高下文变长,(微小的)对不联系token的老成力之和可能向上对少数联系token的老成力,从而统一它们。

这一洞见标明,跟着输入长度的加多,经典Transformer可能越来越难以捕捉到重要信息。DIFF Transformer试图科罚这一问题。

但他仍不祥情对于捕快充分的模子来说这是个多大的问题,但愿在DIFF Transformer论文中有一些对于attention分裂/熵的图表,以内容证据注解这个插图的合感性。

接下来,他指出了几个容易被淡薄的细节:

与Figure1不同,DiffAttn内容上并莫得对差值重新归一化。那么它究竟如何放大”联系”的分数呢?

Beyer建论说文中能提供更多内容捕快的DIFF Transformer的分析图表。

λ的贪图止境复杂,触及两个可学习的指数函数之差,加上一些基线λ_init,在早期的层是0.1,背面又是0.8。

Beyer认为λ不一定需如果偶合,并建议提供更多对可学习λ参数的分析。

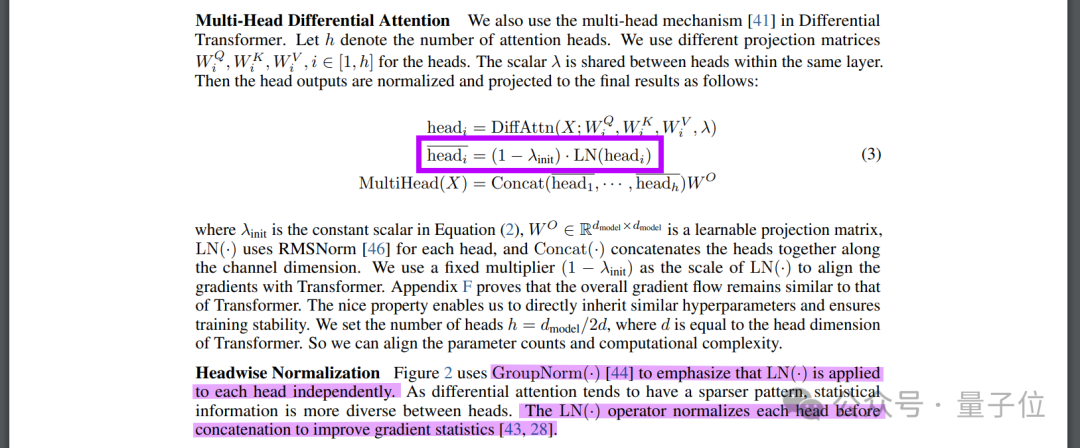

每个老成力头的输出皆经由了层归一化并乘以(1-λ_init),ag百家乐九游会然后再concat并乘以WO,这里也需要更多图表来证据注解。

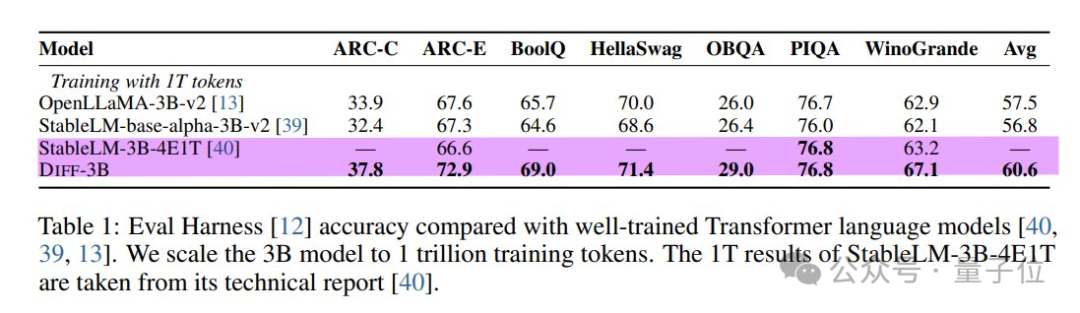

接下来看论文中无数的实际。接头者基本上分叉澄莹StableLM-3B-4E1T,称之为Diff-3B,行为基线模子进行比拟。

可惜的是,基线模子只在其中3个数据集上诠释了成果,其中2个Diff-3B的深入皆止境好。

Beyer怀疑这个StableLM-3B是否确切是一个强基线。

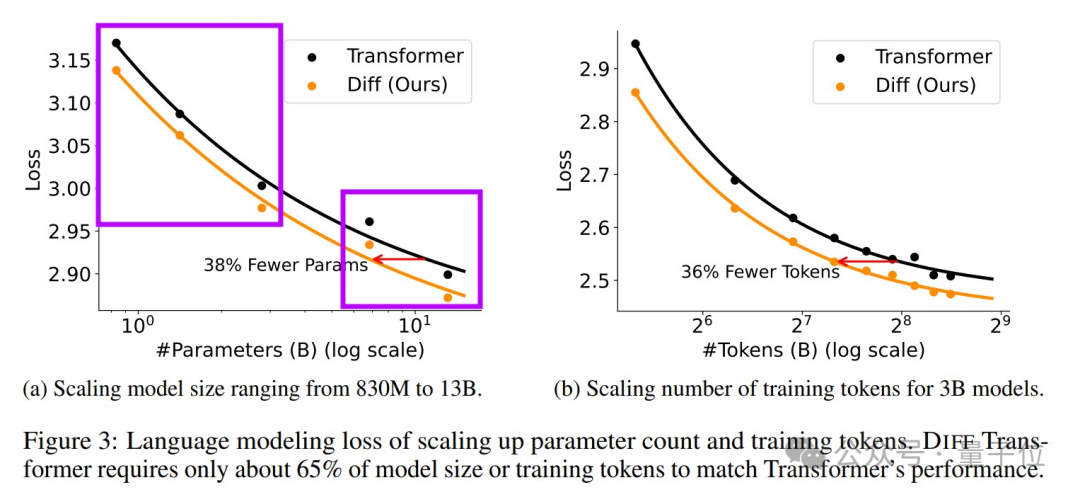

在参数目和token数的缩放弧线上,DIFF Transformer乍一看很有远景。但仔细不雅察后,Beyer提议了两点质疑:

缩放弧线彰着分为两组,在它们之间画一条线有点牵强。搜检附录可知,接头者为较大的两个模子镌汰了学习率。这是否意味着他们遭遇了不深入性问题?

每次实际只用了10B个token捕快,这个数目相称小。Beyer意会其中的贪图资源结束,但仍然感到有点不安。

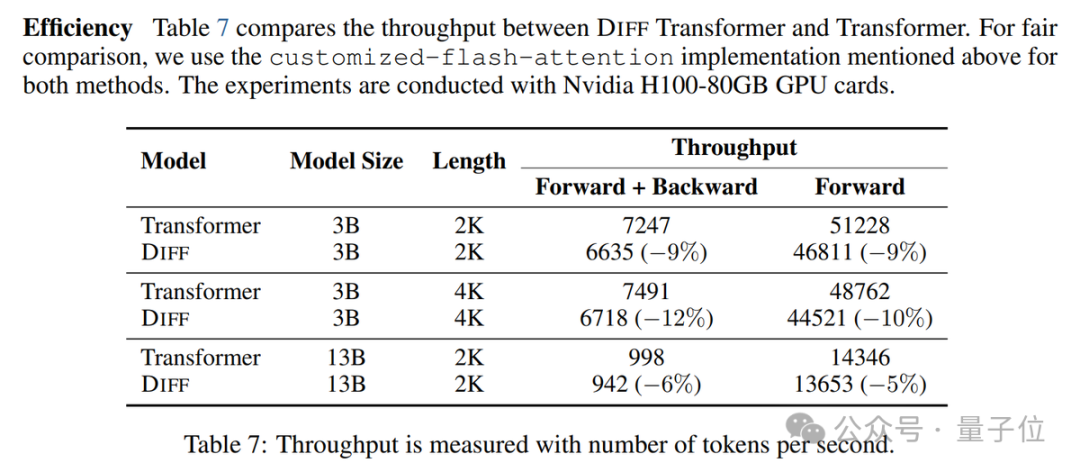

这些实际标明,在调换大小的情况下,DIFF Transformer性能会更好一些,况且捕快时辰调换。

关联词,它的的推理速率也会慢一些(慢5-10%)。

Beyer提议最佳能看到以贪图量或内容时辰为横轴的缩放弧线。

在长文本评测和对输入样本轨则的鲁棒性方面,DIFF Transformer深入出了彰着的上风。

止境是在高下体裁习的鲁棒性实际中,DIFF Transformer在不同的样本罗列轨则下,性能方差远小于经典Transformer。

这标明它更拦截易被输入的微弱变化搅扰,而经典Transformer容易受到样本轨则的影响,在最佳和最坏情况下深入出入很大。

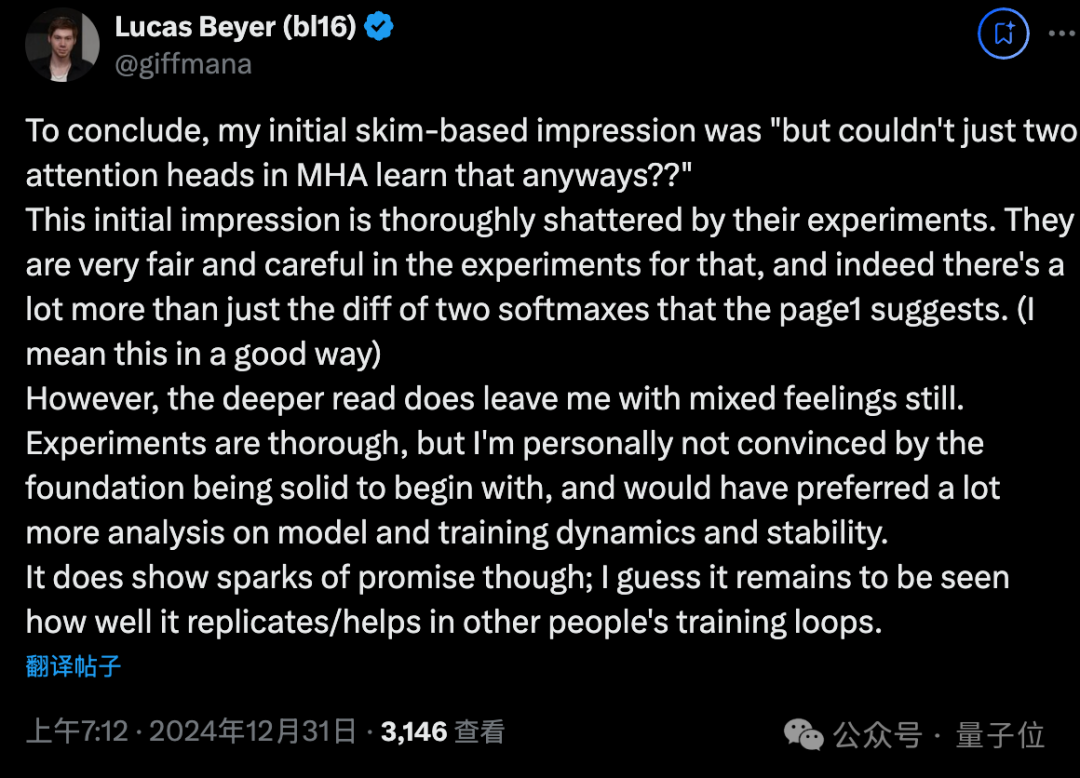

总的来说,Beyer对这篇论文的认识有所改不雅:

接头者的实际相称全面和严慎,实在展现了DIFF Transformer比单纯的”两个老成力头相减”更多的后劲。

这项职责展现了一些有远景的火花。它在其他东说念主的捕快任务中能否很好地复现、或带来匡助,还有待进一步不雅察。

Lucas Beyer是谁

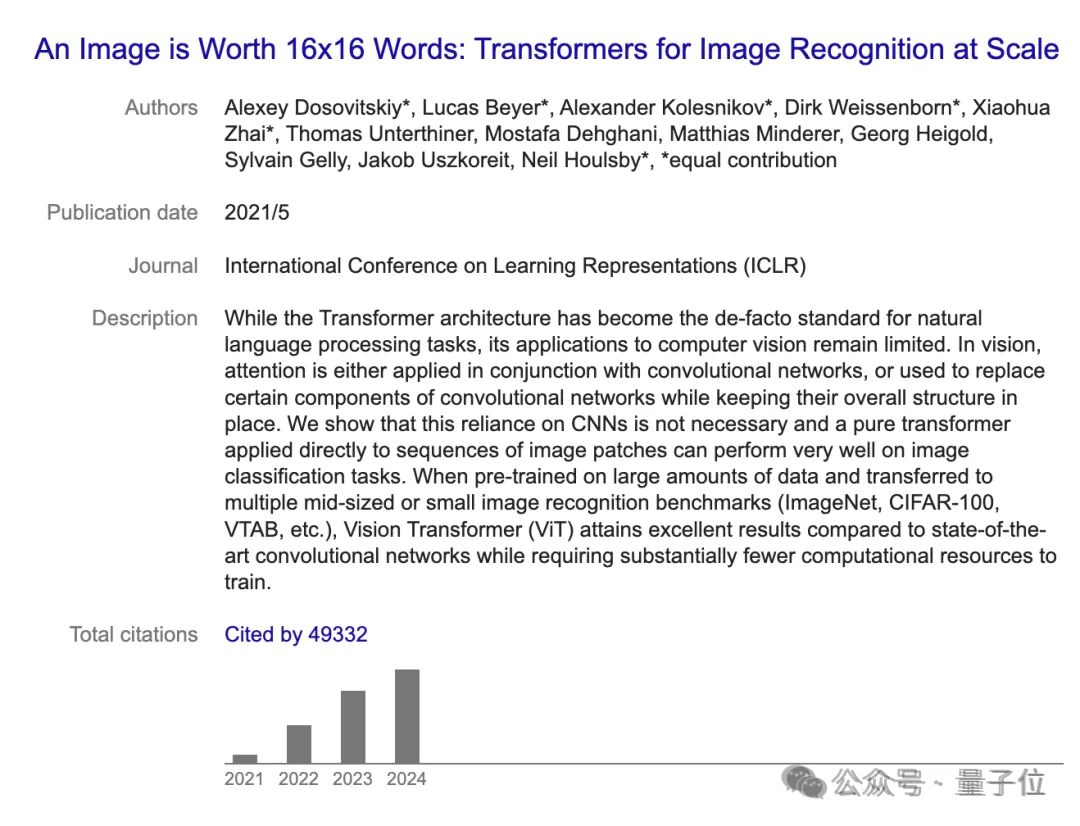

12月初,Lucas Beyer与Xiaohua Zhai、Alexander Kolesnikov集体从谷歌被挖到OpenAI。

他们曾共同提议Vision Transformer,创举了Transformer在CV畛域诈欺的先河。

据他个东说念主官网中先容,他在比利时长大,曾联想制作电子游戏以及从事AI接头。

他在德国亚琛工业大学学习机械工程,并在那处得回了机器东说念主感知和贪图机视觉博士学位,2018年加入谷歌。

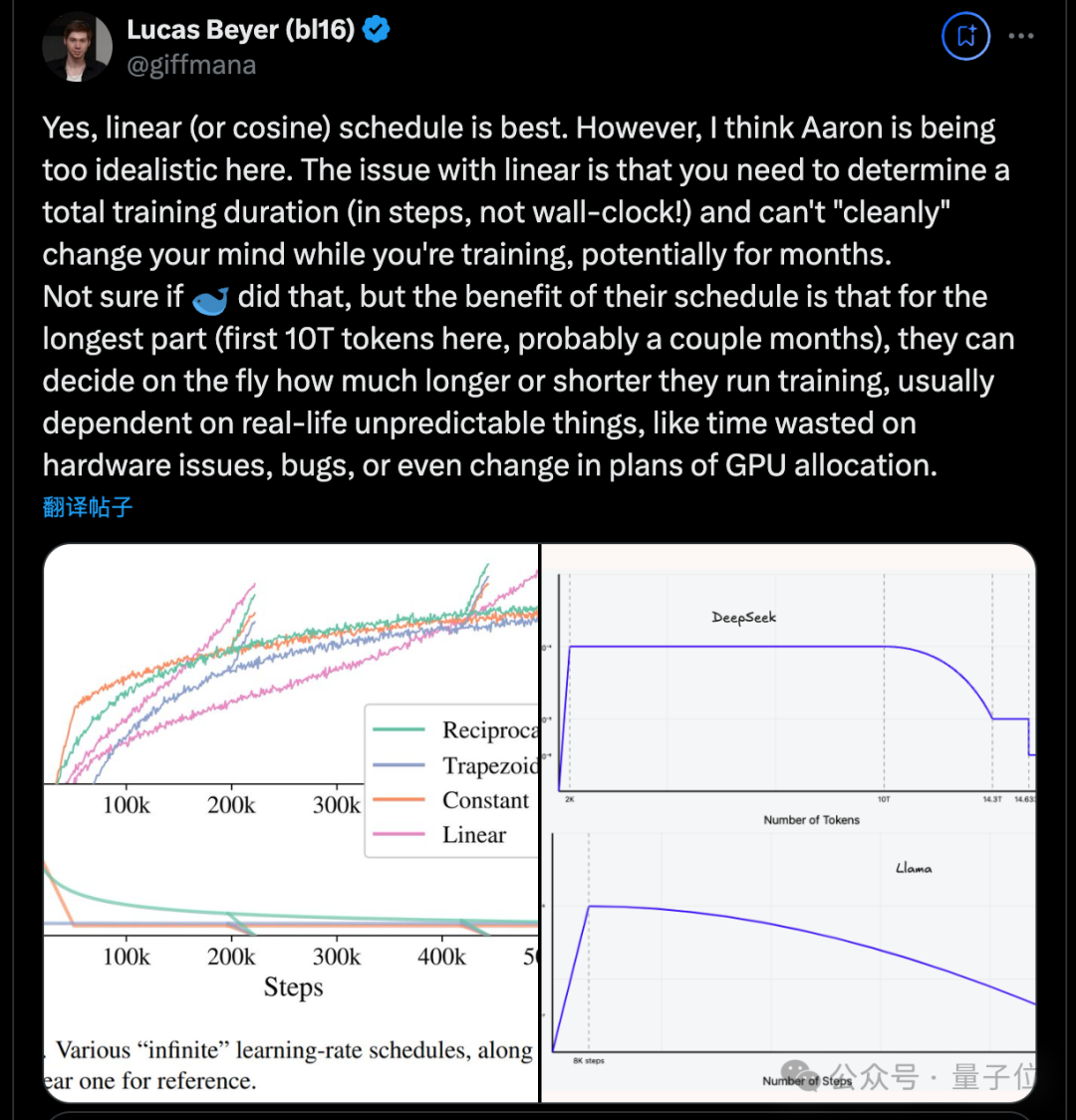

除了此次长文分析DIFF Transformer除外,他还庸俗对新接头发表一些短的驳斥,比如最近火爆的DeepSeek v3,他也提议我方的建议。

总之是一位相称值得温文的学者百家乐ag厅投注限额。